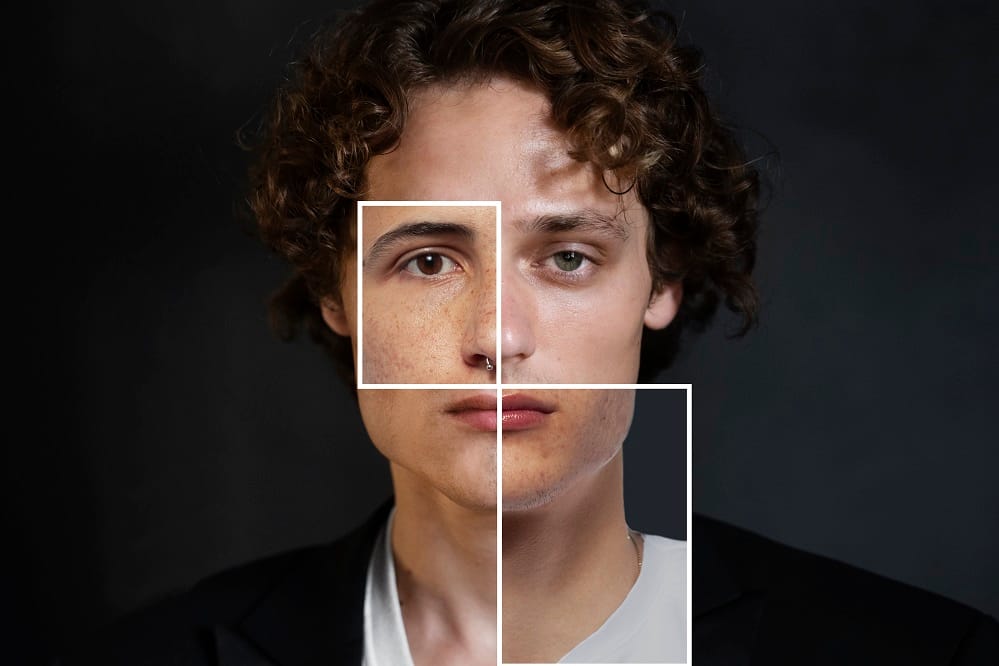

El sesgo algorítmico es un fenómeno que ocurre cuando los algoritmos, utilizados para tomar decisiones o realizar predicciones, reflejan prejuicios presentes en los datos o en el diseño del sistema. A pesar de que los algoritmos de inteligencia artificial (IA) están diseñados para ser objetivos, pueden reproducir o incluso amplificar discriminaciones y desigualdades existentes en la sociedad.

Ejemplos de sesgo algorítmico han aparecido en múltiples áreas, desde sistemas de selección de personal que discriminan a candidatos por su género o raza, hasta algoritmos de concesión de crédito que penalizan a ciertos grupos socioeconómicos. Estos problemas surgen cuando los datos con los que se entrena a la IA no son lo suficientemente diversos o cuando los modelos no se diseñan para corregir estas desigualdades.

Abordar el sesgo algorítmico es crucial porque estos sistemas se están utilizando cada vez más en decisiones que afectan a la vida de las personas, desde el ámbito laboral hasta el judicial. Si no se gestiona correctamente, la IA corre el riesgo de perpetuar injusticias y desigualdades, en lugar de solucionarlas.

Causas del sesgo en los algoritmos

El sesgo algorítmico tiene diversas causas, muchas de las cuales están vinculadas a cómo se entrenan y desarrollan los algoritmos de inteligencia artificial. A continuación, veremos algunas de las principales fuentes de este problema.

1. Datos de entrenamiento defectuosos o incompletos

La calidad de los datos es fundamental para el rendimiento de los algoritmos de IA. Cuando los datos utilizados para entrenar un algoritmo son parciales o no representan adecuadamente la diversidad del mundo real, el modelo puede aprender patrones sesgados. Por ejemplo, si en un conjunto de datos de selección de personal hay una subrepresentación de mujeres o minorías, el algoritmo podría aprender a valorar menos sus candidaturas, replicando así los prejuicios del pasado.

2. Prejuicios inherentes en los modelos matemáticos

Incluso si los datos son de alta calidad, los modelos matemáticos utilizados para desarrollar los algoritmos pueden introducir sesgos. Algunos algoritmos tienden a favorecer las tendencias mayoritarias o las correlaciones más frecuentes, lo que puede perjudicar a grupos minoritarios o con características atípicas. Este fenómeno se conoce como sesgo del modelo y puede surgir simplemente porque el algoritmo optimiza para la precisión general, sin tener en cuenta las diferencias entre grupos.

3. Influencia de las decisiones humanas en el diseño del algoritmo

Los algoritmos no se desarrollan en el vacío; son creados por seres humanos que toman decisiones sobre qué variables incluir, cómo definir el éxito o fracaso de un modelo y cómo entrenarlo. Estas decisiones, conscientes o no, pueden introducir sesgos en el sistema. Si los diseñadores no consideran explícitamente la equidad y la inclusión durante el proceso de desarrollo, el algoritmo puede terminar reflejando las mismas desigualdades que intentamos evitar.

Impacto del sesgo algorítmico en la sociedad

El sesgo algorítmico afecta de manera significativa a varios sectores donde las decisiones automatizadas están cada vez más presentes. Estas decisiones, tomadas por sistemas de inteligencia artificial, pueden influir en procesos que van desde la contratación de personal hasta el acceso a servicios financieros o la administración de justicia.

1. Sectores afectados por el sesgo algorítmico

- Contratación: Los sistemas de IA utilizados para filtrar currículums o evaluar candidatos pueden reproducir patrones de discriminación presentes en los datos históricos, lo que afecta la equidad en los procesos de selección.

- Crédito financiero: Algunos modelos utilizados por instituciones financieras para la concesión de préstamos o líneas de crédito pueden favorecer a ciertos grupos demográficos, aumentando la desigualdad en el acceso a recursos económicos.

- Justicia: El uso de sistemas algorítmicos en ámbitos judiciales puede influir en decisiones clave, como la concesión de fianzas o la evaluación del riesgo de reincidencia, con potenciales consecuencias injustas.

2. Consecuencias sociales y éticas

El impacto de estos sesgos en los algoritmos puede perpetuar desigualdades preexistentes en la sociedad, especialmente cuando afectan a grupos marginados. Esto plantea importantes desafíos éticos sobre el uso de la IA en procesos que tradicionalmente requieren intervención humana. Es fundamental que las empresas tecnológicas y las organizaciones que implementan estos sistemas sean conscientes de las implicaciones éticas y trabajen en corregir estos problemas para asegurar un uso justo y equitativo de la tecnología.

Cómo identificar el sesgo en algoritmos de IA

Identificar el sesgo en los algoritmos de inteligencia artificial es un paso crucial para mitigar su impacto. Debido a la complejidad de estos sistemas, es esencial implementar métodos y herramientas específicos para detectar posibles desigualdades antes de que los modelos se desplieguen en entornos reales.

1. Métodos para detectar el sesgo en los datos y los modelos

El sesgo en un algoritmo puede tener su origen en los datos de entrenamiento o en el propio modelo. Por ello, es importante auditar los datos desde el inicio. Algunas de las técnicas más comunes incluyen:

- Análisis estadístico de la diversidad de los datos: Evaluar si los datos de entrenamiento reflejan adecuadamente la diversidad del mundo real. Es esencial asegurarse de que todos los grupos relevantes estén representados de manera equilibrada.

- Pruebas de equidad: Realizar análisis comparativos para comprobar si el algoritmo trata a los diferentes grupos de manera equitativa. Esto implica probar el modelo con diferentes subgrupos demográficos para identificar discrepancias en los resultados.

2. Herramientas tecnológicas para la auditoría de IA

Existen herramientas diseñadas específicamente para auditar el sesgo en los sistemas de IA. Algunas de ellas son:

- AI Fairness 360: Una herramienta de código abierto desarrollada por IBM que proporciona métricas y algoritmos para identificar y mitigar el sesgo en los datos y modelos de IA.

- Fairlearn: Un kit de herramientas desarrollado por Microsoft que ayuda a auditar modelos de IA para detectar el sesgo y generar informes de equidad.

- Fairness indicators: De Google, permite monitorizar el comportamiento de los modelos a lo largo de diferentes subgrupos poblacionales, ayudando a detectar sesgos en los resultados.

3. Mejores prácticas para la evaluación continua del sesgo

El análisis del sesgo algorítmico no debe ser un proceso único, sino continuo. A medida que los sistemas de IA evolucionan y se enfrentan a nuevos datos, es necesario:

- Monitorizar los resultados en tiempo real: Implementar sistemas de supervisión para evaluar de manera continua cómo se comporta el algoritmo y si está generando resultados sesgados.

- Reentrenar los modelos con datos actualizados: Mantener los modelos de IA al día es esencial para evitar que los sesgos históricos persistan. Recolectar nuevos datos y ajustar los modelos es una de las mejores formas de asegurar una mayor equidad.

- Equipos multidisciplinarios: Involucrar a equipos diversos, no solo desde una perspectiva técnica, sino también desde el ámbito ético y legal, puede ayudar a identificar sesgos que podrían pasar desapercibidos en entornos homogéneos.

Estrategias para mitigar el sesgo en algoritmos de IA

Mitigar el sesgo algorítmico es esencial para garantizar que la inteligencia artificial se utilice de manera justa y equitativa. Existen varias estrategias que pueden ayudar a reducir el sesgo tanto en la fase de recolección de datos como en el desarrollo de los modelos. A continuación, tienes algunas de las más efectivas.

1. Recolección de datos más representativos y balanceados

La base de cualquier sistema de IA es la calidad de los datos que utiliza para su entrenamiento. Para minimizar el sesgo, es crucial asegurarse de que los datos sean lo más representativos posible de la población real. Algunas prácticas clave incluyen:

- Ampliar las fuentes de datos: Recoger datos de diversas fuentes para garantizar que todos los grupos demográficos estén representados.

- Eliminar muestras sesgadas: Identificar y corregir desequilibrios en los datos que puedan favorecer a ciertos grupos en detrimento de otros.

- Preprocesamiento de los datos: Aplicar técnicas de preprocesamiento para corregir desbalances en los datos de entrenamiento, como el sobremuestreo de clases subrepresentadas.

2. Algoritmos de corrección del sesgo (bias correction)

Además de trabajar en los datos, existen enfoques específicos que se pueden aplicar a los algoritmos para corregir el sesgo inherente. Algunas de las técnicas más comunes incluyen:

- Regularización de equidad: Introducir penalizaciones en los modelos para reducir la disparidad en los resultados entre diferentes grupos demográficos.

- Ajuste de umbrales: Modificar los umbrales de decisión del algoritmo para equilibrar los resultados entre distintos grupos.

- Debiasing: Aplicar técnicas que detectan y corrigen automáticamente los sesgos en las predicciones del algoritmo, ajustando los pesos de manera que los resultados sean más equitativos.

3. Equipos diversos en el desarrollo y evaluación de los algoritmos

La diversidad en los equipos de desarrollo es crucial para detectar y mitigar sesgos. Un grupo diverso de personas, con diferentes orígenes, experiencias y puntos de vista, está mejor equipado para identificar problemas que podrían pasar desapercibidos en un entorno más homogéneo. Algunas buenas prácticas incluyen:

- Formación en ética y sesgo algorítmico: Asegurarse de que los equipos de desarrollo estén formados en temas de ética y sean conscientes de los posibles impactos de los sesgos en la IA.

- Colaboración multidisciplinaria: Involucrar a expertos en ética, derecho y sociología en el proceso de diseño y evaluación de los algoritmos, para abordar los posibles sesgos desde diferentes perspectivas.

- Evaluación continua por equipos diversos: Los sistemas de IA deben ser revisados de manera regular por equipos diversos, no solo en su creación, sino a lo largo de todo su ciclo de vida.

Conclusión

El sesgo algorítmico representa un desafío crítico en el desarrollo de la inteligencia artificial. Para garantizar que la IA beneficie a todos, es fundamental aplicar una vigilancia constante sobre los sistemas, corregir los sesgos de manera proactiva y adoptar políticas y regulaciones que promuevan la equidad. Solo a través de un enfoque ético y colaborativo, entre desarrolladores y reguladores, lograremos una IA más justa y equitativa para el futuro.

¿Crees que las regulaciones actuales sobre inteligencia artificial son suficientes para mitigar los sesgos?

¿Qué otras medidas propondrías para hacer la IA más justa?

Fuentes: